Introducción: Más Allá del Simple Chatbot. Un Agente de IA de Grado Empresarial (*Production-Ready*) es un sistema de software capaz de percibir su entorno, razonar de manera autónoma y actuar para alcanzar objetivos específicos. Este enfoque trasciende la funcionalidad reactiva de un chatbot simple, exigiendo una arquitectura robusta, segura y escalable, esencial para las PyMEs que buscan una ventaja competitiva.

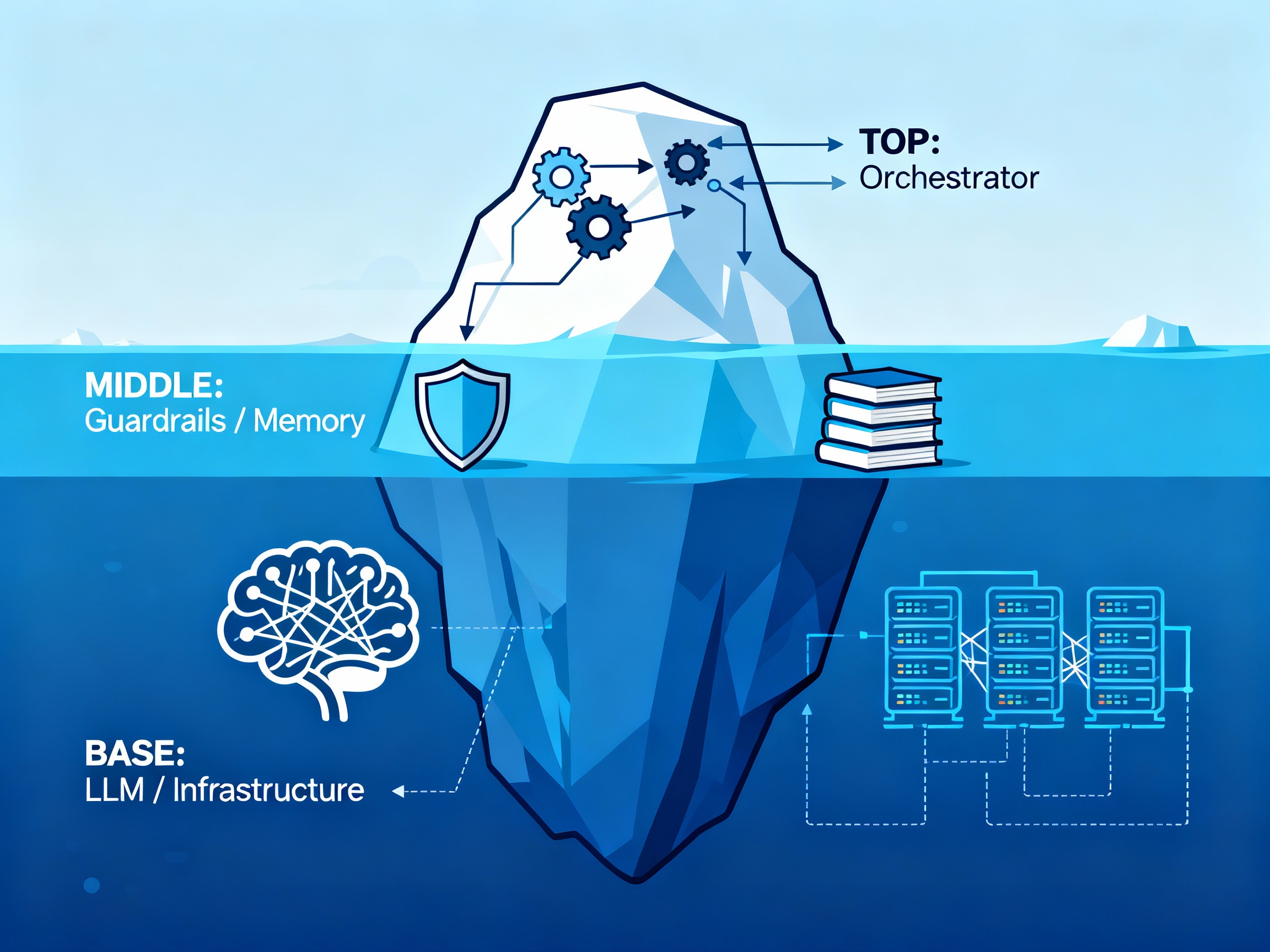

I. Bloques de Construcción Esenciales: La Arquitectura del Iceberg

La arquitectura de un Agente de IA se estructura como un iceberg, donde las capas superiores son las funciones de coordinación y las inferiores son la infraestructura fundamental. Neblina implementa esta arquitectura localmente para un control máximo y seguridad de los datos:

| Nivel | Bloque de Construcción | Función Principal |

|---|---|---|

| Punta | Orquestador y Registro de Agentes | Coordina la interacción, gestiona el flujo de ejecución y selecciona al agente adecuado para cada tarea. |

| Superior | Gestión Contextual y Memoria | Permite al agente recordar información relevante a corto plazo (Contexto Operacional) y a largo plazo (Memoria Persistente). |

| Medio | Guardarraíles, Gobernanza y Seguridad | Mecanismos de auditoría y límites para asegurar que el agente opera de forma ética y dentro de las reglas predefinidas. |

| Base | Plataforma e Infraestructura | El motor del Agente Autónomo (LLM) y el entorno tecnológico subyacente que aloja todos los componentes. |

II. Pilares Técnicos Fundamentales

Dos áreas técnicas son críticas para la fiabilidad de la plataforma: la gestión de la memoria y la ingeniería de contexto.

1. Gestión de la Memoria

La memoria de un agente se divide para manejar diferentes horizontes de tiempo y complejidad:

- Memoria de Corto Plazo: Equivalente a la Ventana de Contexto. Almacena el historial de la conversación actual y se borra al finalizar la sesión.

- Memoria a Largo Plazo: Equivalente a la Base de Conocimientos. Información persistente almacenada típicamente en una Base de Datos Vectorial y recuperada mediante RAG (Generación Aumentada por Recuperación).

- Consejo de Consulta: El registro en la memoria a largo plazo debe ser explícito y trazado por razones de auditoría, nunca implícito.

2. Ingeniería de Contexto

Consiste en suministrar la información correcta y optimizada al LLM en el momento justo. Esto es clave para prevenir 'alucinaciones' y asegurar acciones fiables.

Las estrategias utilizadas incluyen Ingeniería de Prompt avanzada, RAG, gestión del historial de conversación, filtrado semántico y anonimización de datos.

III. Introducción a los Principios de Arquitectura y Gobernanza

La implementación exitosa de Agentes de IA requiere adherirse a principios de gobernanza estrictos. Profundizaremos en estos principios en detalle en la Parte 2, pero aquí están las bases:

- Alineación de Objetivos: Cada agente debe estar alineado con un objetivo de negocio simple y medible (Comience por el principio de la 'Hormiga').

- Seguridad por Diseño: La seguridad debe integrarse en cada fase, aplicando el principio de menor privilegio, especialmente al ejecutarse en servidores locales.

- Observabilidad: La observabilidad fina (latencia, decisiones, uso de herramientas) es obligatoria para detectar rápidamente desviaciones y 'alucinaciones'.

Continúe su viaje en la Parte 2, donde revelaremos los 10 Principios de Arquitectura y Gobernanza esenciales para llevar a los Agentes de IA del piloto a la producción.