Mientras que la Parte 1 estableció los componentes arquitectónicos (Iceberg y Blueprint), esta segunda parte se centra en el punto de fallo más común para los proyectos de IA: la transición del piloto a la producción. El éxito depende de adoptar principios rigurosos de gobernanza y operativos (MLOps).

Columnas Técnicas Fundamentales (Revisión)

Antes de la implementación, dos áreas—Gestión de la Memoria e Ingeniería de Contexto—deben perfeccionarse para minimizar el riesgo del modelo.

1. Gestión de la Memoria

La estructura de memoria del agente es clave para la fiabilidad a largo plazo. Utilizamos Bases de Datos Vectoriales (RAG) para el conocimiento persistente, asegurando que el agente utilice datos privados y locales como base fáctica, en lugar de recurrir a su entrenamiento público general.

2. Ingeniería de Contexto

Consiste en suministrar la información correcta y optimizada al LLM en el momento justo. Esto es clave para prevenir 'alucinaciones' y asegurar acciones fiables.

Las estrategias utilizadas incluyen Ingeniería de Prompt avanzada, RAG, gestión del historial de conversación, filtrado semántico y anonimización de datos.

10 Principios de Arquitectura y Gobernanza

La adopción de estos 10 Principios de Arquitectura es fundamental para el éxito en producción y para minimizar el riesgo de fracaso empresarial (Gartner estima que el 70% de los pilotos de IA fracasan por problemas de gobernanza).

- Comience por la 'Hormiga': Alinee cada agente con un objetivo simple y medible. El fracaso de los agentes complejos a menudo comienza con un objetivo demasiado amplio.

- Seguridad por Concepción: Integre la seguridad en cada fase, aplicando el principio de menor privilegio. Esto es especialmente cierto para implementaciones locales que acceden a bases de datos propietarias.

- Modularidad (Un Agente, Una Tarea): Privilegie agentes especializados y colaborativos sobre un sistema monolítico. Esto simplifica mucho la depuración, actualización y escalado.

- Piense 'Herramientas' antes que 'Razonamiento': El valor del agente reside en sus acciones. Priorice toolkits robustos (APIs) que permitan al agente interactuar de forma segura con sistemas de negocio externos.

- Gobernar desde el Primer Día: Implemente el registro (*logging*), la trazabilidad y el control desde el inicio. El *logging* es la única forma de auditar y diagnosticar fallos con precisión.

- El Humano como Guardarraíl: La aprobación humana es obligatoria para acciones críticas e irreversibles. El sistema debe 'pedir ayuda' en lugar de ejecutar una operación de alto riesgo de forma autónoma.

- Diseñar para el Fracaso: Prevea el fracaso. Anticipe mecanismos de reintento y degradación elegante para manejar las alucinaciones del LLM sin colapsar todo el sistema.

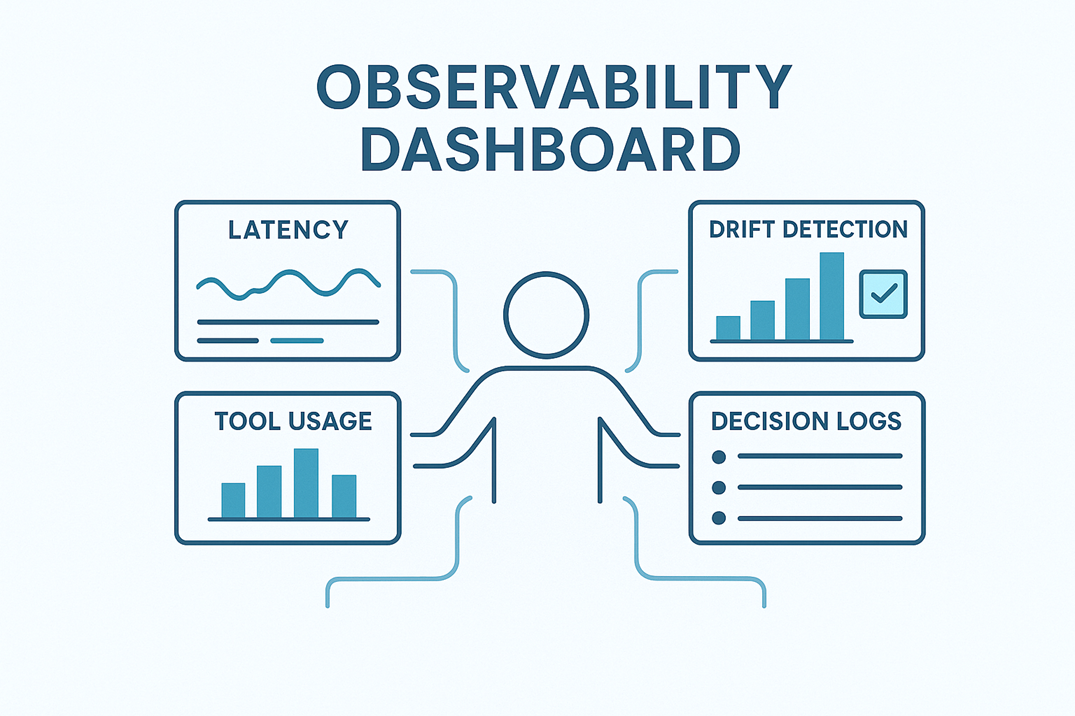

- Observar no es una Opción: Despliegue observabilidad fina (latencia, decisiones, uso de herramientas) para detectar *drift* y desviaciones. Si no puede medirlo, no puede gobernarlo.

- Evaluación en Continuo: Ponga en marcha *frameworks* de *tests* automatizados para validar la precisión y el rendimiento del agente de forma continua, especialmente después de un ciclo de reentrenamiento.

- La Simplicidad es la Clave: Un agente simple y fiable en producción vale más que un sistema complejo no funcional. Apunte a la complejidad incremental.

Advertencia: Gartner estima que el 70% de los proyectos de IA fracasan al pasar a producción, no por la tecnología en sí, sino por la sub-estimación de las exigencias en materia de Gobernanza y Operaciones. Trate cada desafío técnico como un riesgo de negocio.